リソース定義@Kubernetes¶

はじめに¶

本サイトにつきまして、以下をご認識のほど宜しくお願いいたします。

APIService¶

.spec.group¶

▼ groupとは¶

拡張apiserverが受信するAPIグループ名を設定する。

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

group: foo.k8s.io

.spec.groupPriorityMinimum¶

▼ groupPriorityMinimumとは¶

同じAPIグループがある場合に、優先度を設定する。

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

groupPriorityMinimum: 100

.spec.insecureSkipTLSVerify¶

▼ insecureSkipTLSVerifyとは¶

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

insecureSkipTLSVerify: true

.spec.service¶

▼ serviceとは¶

拡張apiserverは、kube-apiserverからリクエストを直接的に受信するのではなく、専用のServiceを介してリクエストを受信する。この時、どのServiceからリクエストを受信するかを設定する。

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

service:

name: foo-service

namespace: kube-system

port: 443

.spec.version¶

▼ versionとは¶

拡張apiserverが受信するAPIグループのバージョンを設定する。

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

version: v1beta1

.spec.versionPriority¶

▼ versionPriorityとは¶

同じAPIグループがある場合に、バージョンの優先度を設定する。

apiVersion: apiregistration.k8s.io/v1

kind: APIService

metadata:

name: v1beta1.foo.k8s.io

spec:

versionPriority: 100

CertificateSigningRequest¶

.spec.request¶

▼ requestとは¶

base64方式でエンコードした証明書署名要求 (.csr ファイル) を設定する。

apiVersion: certificates.k8s.io/v1

kind: CertificateSigningRequest

metadata:

name: foo-csr

spec:

groups:

- system:authenticated

# base64方式でエンコードした証明書署名要求ファイル

request: LS0tL...

signerName: kubernetes.io/kube-apiserver-client

usages:

- digital signature

- key encipherment

- client auth

定義したCertificateSigningRequestを承認し、サーバー証明書 (.crt) を作成するためには、kubectl certificate approve コマンドを使用する。

# 承認

$ kubectl certificate approve foo-csr

# サーバー証明書を取得する。

$ kubectl get csr foo-csr -o jsonpath='{.status.certificate}'| base64 -d > foo.crt

Config¶

clusters¶

▼ clustersとは¶

kubectl コマンドの向き先となるClusterを設定する。

▼ name¶

Cluster名を設定する。

apiVersion: v1

kind: Config

clusters:

- name: <ClusterのARN>

...

- name: docker-desktop

...

- name: minikube

...

▼ cluster¶

kub-apiserverの接続先情報を設定する。

apiVersion: v1

kind: Config

clusters:

- cluster:

# kube-apiserverのサーバー証明書

certificate-authority-data: LS0tLS1 ...

# kube-apiserverのURL

server: https://*****.gr7.ap-northeast-1.eks.amazonaws.com

...

- cluster:

certificate-authority-data: LS0tLS1 ...

server: https://kubernetes.docker.internal:6443

...

- cluster:

certificate-authority: /Users/hiroki-hasegawa/.minikube/ca.crt

extensions:

- extension:

last-update: Fri, 13 May 2022 16:58:59 JST

provider: minikube.sigs.k8s.io

version: v1.25.2

name: cluster_info

server: https://127.0.0.1:52192

...

contexts¶

▼ contextsとは¶

kubectl コマンドの向き先の候補を設定する。

▼ name¶

向き先の名前を設定する。

apiVersion: v1

kind: Config

contexts:

- name: <ClusterのARN>

...

- name: docker-desktop

...

- name: minikube

...

▼ context¶

実際に使用するCluster名とServiceAccountユーザー名を、.contexts[*].context.cluster キーと .contexts[*].context.user キーから選んで設定する。

apiVersion: v1

kind: Config

contexts:

- context:

cluster: <ClusterのARN>

user: <ClusterのARN>

...

- context:

cluster: docker-desktop

user: docker-desktop

...

- context:

cluster: minikube

extensions:

- extension:

last-update: Fri, 13 May 2022 16:58:59 JST

provider: minikube.sigs.k8s.io

version: v1.25.2

name: context_info

namespace: default

user: minikube

...

current-context¶

▼ current-contextとは¶

kubectl コマンドの現在の向き先の名前を設定する。

apiVersion: v1

kind: Config

current-context: <ClusterのARN>

preferences¶

▼ preferencesとは¶

apiVersion: v1

kind: Config

preferences: {}

users¶

▼ usersとは¶

kube-apiserverのクライアント (特に kubectl コマンド実行者) のUserAccountの情報を設定する。

▼ name¶

ユーザー名を設定する。

apiVersion: v1

kind: Config

users:

- name: <ClusterのARN>

...

- name: docker-desktop

...

- name: minikube

▼ user¶

ユーザーの資格情報を設定する。

AWS EKSのように、資格情報を動的に取得するようにしても良い。

apiVersion: v1

kind: Config

users:

- user:

exec:

apiVersion: client.authentication.k8s.io/v1

args:

- --region

- ap-northeast-1

- eks

- get-token

- --cluster-name

- prd-foo-eks-cluster

command: "aws"

...

- user:

client-certificate-data: LS0tLS1 ...

client-key-data: LS0tLS1 ...

...

- user:

client-certificate: /Users/hiroki-hasegawa/.minikube/profiles/minikube/client.crt

client-key: /Users/hiroki-hasegawa/.minikube/profiles/minikube/client.key

...

ConfigMap¶

data¶

▼ dataとは¶

Kubernetesリソースに渡す機密でない変数を設定する。

▼ 変数の管理¶

ConfigMapに設定する変数を設定する。

apiVersion: v1

kind: ConfigMap

metadata:

name: foo-config-map

data:

bar: BAR

string型しか設定できないため、デコード後にinteger型やboolean型になってしまう値は、ダブルクオーテーションで囲う必要がある。

apiVersion: v1

kind: ConfigMap

metadata:

name: foo-config-map

data:

enableFoo: true # ダブルクオーテーションで囲う。

number: "1"

▼ ファイルに管理¶

パイプ (|) を使用すれば、ファイルを変数として設定できる。

apiVersion: v1

kind: ConfigMap

metadata:

name: foo-fluent-bit-conf-config-map

data:

fluent-bit.conf: |

[SERVICE]

Flush 1

Log_Level info

[OUTPUT]

Name cloudwatch

Match *

region ap-northeast-1

log_group_name /prd-foo-k8s/log

log_stream_prefix container/fluent-bit/

auto_create_group true

CronJob¶

.spec.concurrencyPolicy¶

▼ concurrencyPolicy¶

CronJob配下のJobの並列処理ルールを設定できる。

▼ Allow¶

Jobの並列処理を許可する。

▼ Forbid¶

Jobの並列処理を拒否する。

▼ Allow¶

もし別のJobを実行していれば、そのJobを停止して新しくJobを実行する。

.spec.jobTemplate¶

▼ jobTemplateとは¶

CronJobで、定期的に実行するJobを設定する。

apiVersion: batch/v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

# 毎日 00:00 (JST) に実行する

schedule: "0 15 * * *"

jobTemplate:

spec:

template:

spec:

containers:

- name: foo-alpine

image: alpine:latest

# 定期的に実行するコマンドを設定する。

command:

- /bin/bash

- -c

args:

- echo Hello World

restartPolicy: OnFailure

.spec.failedJobsHistoryLimit¶

▼ failedJobsHistoryLimitとは¶

実行に失敗したJobに関して、上限の履歴数を設定する。

apiVersion: io.k8s.api.batch.v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

failedJobsHistoryLimit: 2

.spec.schedule¶

▼ scheduleとは¶

Cronのルールを設定する。

apiVersion: io.k8s.api.batch.v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

# 1時間ごとに実行する

schedule: "00 * * * *"

なお、タイムゾーンはKubernetes Clusterの設定による。

例えば、AWS EKS ClusterはUTCで時間を管理しているため、9時間分ずらす必要がある。

apiVersion: io.k8s.api.batch.v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

# 毎日 00:00 (JST) に実行する

schedule: "0 15 * * *"

.spec.startingDeadlineSeconds¶

▼ startingDeadlineSeconds¶

JobがCronのスケジュール通りに実行されなかった場合、実行の遅れを何秒まで許容するかを設定する。

指定した秒数を過ぎると、実行を失敗とみなす。

apiVersion: io.k8s.api.batch.v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

startingDeadlineSeconds: 100

CronJobのデフォルトの仕様として、Jobが 100 回連続で失敗すると、CronJobを再作成しない限りJobを再実行できなくなる。

1時間にJobを1回実行すると仮定すると、簡単に 100 回を超過してしまう。

停止時間 (8h) * 実行間隔 (60/h) = 480回

この時、.spec.startingDeadlineSeconds キーを設定しておくと、これの期間に 100 回連続で失敗したときのみ、Jobを再実行できなくなる。

100 回連続を判定する期間を短くすることで、再作成しなくてもよくなるようにする。

.spec.successfulJobsHistoryLimit¶

▼ successfulJobsHistoryLimitとは¶

実行に成功したJobに関して、上限の履歴数を設定する。

apiVersion: batch/v1

kind: CronJob

metadata:

name: foo-cronjob

spec:

successfulJobsHistoryLimit: 2

DaemonSet¶

.spec.replicas¶

Deploymentと同じである。

.spec.strategy¶

.spec.strategy (RollingUpdateの場合)¶

Podで .spec.containers[*].ports[*].hostPort キーを使用する場合、.spec.strategy.rollingUpdate.maxSurge キーは 0 (デフォルト値) にしなければならない。

Deployment¶

.spec.replicas¶

▼ replicasとは¶

Cluster内で維持するPodのレプリカ数を設定する。

Cluster内に複数のNodeが存在していて、いずれかのNodeが停止した場合、稼働中のNode内でレプリカ数を維持するようにPod数が増加する。

HorizontalPodAutoscalerを使用する場合、レプリカ数はHPAが決めるため .spec.replicas は設定不要である。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

# HorizontalPodAutoscalerを使用する場合、.spec.replicasは設定不要である

replicas: 2

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

.spec.revisionHistoryLimit¶

▼ revisionHistoryLimitとは¶

保管されるリビジョンの履歴数を設定する。

もし依存のリビジョンにロールバックする場合があるのであれば、必要数を設定しておく。

デフォルトは 10 個で、個人的にこれは多い。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

revisionHistoryLimit: 5

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

.spec.selector¶

▼ selectorとは¶

Deploymentで管理するPodを明示的に設定する。

▼ matchLabels¶

Podの .metadata.labels キーを指定する。

Podに複数の .metadata.labels キーが付与されているときは、これらを全て指定する必要がある。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

selector:

matchLabels: # Deploymentに紐付けるPodのmetadata.labelsキー

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels: # Podのmetadata.labelsキー

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

▼ field is immutable¶

Deploymentの .spec.selector.matchLabels キーの値は変更できないため、もしこの値を変更する場合は、Deploymentを再作成する必要がある。

例えば、以下のマニフェストの .spec.selector.matchLabels キーの値を変更しようとする。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

selector:

matchLabels:

app.kubernetes.io/name: foo-pod # 変更しようとする

app.kubernetes.io/component: app # 変更しようとする

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

すると、以下のようなエラーになってしまう。

v1.LabelSelector{MatchLabels:map[string]string{"app.kubernetes.io/name":"foo-pod", "app.kubernetes.io/component":"app"}, MatchExpressions:[]v1.LabelSelectorRequirement(nil)}: field is immutable

.spec.strategy¶

▼ strategyとは¶

デプロイメントの方法を設定する。

以下のタイミングでDeploymentはPodを再デプロイする。

| 箇所 | 説明 |

|---|---|

.spec.replicas キー |

Podのレプリカ数を変更すると、DeploymentはPodを再デプロイする。 |

.spec.template キー配下の任意のキー |

Podテンプレートを変更した場合、DeploymentはPodを再デプロイする。 |

.spec.strategy.type (Recreateの場合)¶

▼ Recreateとは¶

インプレースデプロイメントを使用して、新しいPodを作成する。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

strategy:

type: Recreate

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

.spec.strategy (RollingUpdateの場合)¶

▼ RollingUpdateとは¶

ローリングアップデートを使用して、新しいPodを作成する。

ダウンタイムなしでPodを入れ替えられる。

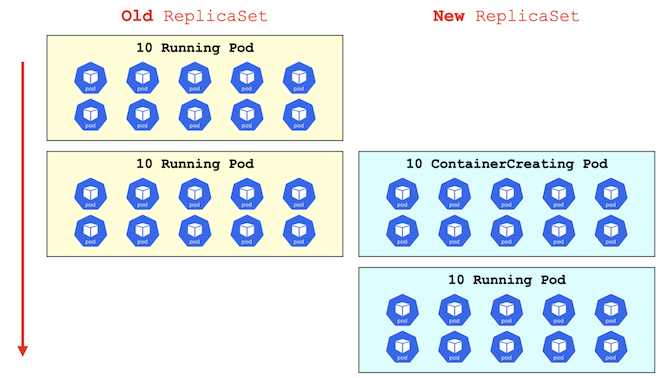

▼ ブルーグリーン方式 (パーセントの場合)¶

もし .spec.strategy.rollingUpdate.maxSurge キーを 100%、また .spec.strategy.rollingUpdate.maxUnavailable キーを 0%とすると仮定する。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

# レプリカ数は10とする

replicas: 10

strategy:

type: RollingUpdate

rollingUpdate:

# デプロイ時に、Podのレプリカ数の50% (5個) だけ、新しいPodを並行的に作成する

maxSurge: 100%

# デプロイ時に、Podのレプリカ数の0% (0個) が停止している状態にならないようにする

maxUnavailable: 00%

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

この場合、RollingUpdate戦略時に、Podのレプリカ数と同じ数だけ新しいPodを作成するようになる。

.spec.strategy.rollingUpdate.maxSurge キーにより、10 個の新しいPodを並行的に作成する (つまり、デプロイ時に新旧Podが合計 20 個ある) 。

.spec.strategy.rollingUpdate.maxUnavailable キーにより、0 個が停止している状態を避ける (停止するPodがない)。

また、Podの停止数がレプリカ数を下回らないようになる。

▼ ブルーグリーン方式 (絶対値の場合)¶

もし .spec.strategy.rollingUpdate.maxSurge キーを 10、また .spec.strategy.rollingUpdate.maxUnavailable キーを 0 と仮定する。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

# レプリカ数は10とする

replicas: 10

strategy:

type: RollingUpdate

rollingUpdate:

# デプロイ時に、Podのレプリカ数の10個だけ、新しいPodを並行的に作成する

maxSurge: 10

# デプロイ時に、Podのレプリカ数の0個が停止している状態にならないようにする

maxUnavailable: 0

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

この場合、RollingUpdate戦略時に、Podのレプリカ数と同じ数だけ新しいPodを作成するようになる。

.spec.strategy.rollingUpdate.maxSurge キーにより、10 個の新しいPodを並行的に作成する (つまり、デプロイ時に新旧Podが合計 20 個ある)。

.spec.strategy.rollingUpdate.maxUnavailable キーにより、0 個が停止している状態を避ける (停止するPodがない)。

また、Podの停止数がレプリカ数を下回らないようになる。

.spec.template¶

▼ templateとは (設定項目はPodと同じ)¶

Deploymentで維持管理するPodテンプレートを設定する。

設定項目はPodと同じである。

Deployment自体の .metadata.labels キーを更新した場合、Podは再作成しない。しかし、.spec.template キー配下の .metadata.labels キーの場合、Podは再作成する。

*実装例*

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

app.kubernetes.io/component: app

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

EndpointSlice¶

.spec.endpoints¶

▼ endpointsとは¶

Serviceでルーティング先のPodに関して、『現在の』 宛先情報を設定する。

Kubernetesが自動的に更新するため、ユーザーが管理する必要はない。

▼ addresses¶

Podの現在のIPアドレスを設定する。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

endpoints:

- addresses:

- *.*.*.*

▼ condition¶

Podの現在のライフサイクルフェーズを設定する。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

endpoints:

- conditions:

ready: true

serving: true

terminating: false

▼ nodeName¶

PodをスケジューリングさせているNode名を設定する。

これにより、Serviceとそのルーティング先のPodが異なるNode上に存在していたとしても、ServiceはPodにルーティングできる。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

endpoints:

- nodeName: foo-node

▼ targetRef¶

Podの識別子を設定する。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

endpoints:

- targetRef:

kind: Pod

name: foo-pod

namespace: foo-namespace

▼ zone¶

PodをスケジューリングさせているAZを設定する。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

endpoints:

- zone: ap-northeast-1a

.spec.ports¶

▼ portsとは¶

Podが待ち受けるポート番号を設定する。

Kubernetesが自動的に更新するため、ユーザーが管理する必要はない。

apiVersion: discovery.k8s.io/v1

kind: EndpointSlice

metadata:

name: foo-endpoint-slice

ports:

- name: http-foo

port: 443

protocol: TCP

HTTPRoute¶

parentRefs¶

紐づけるGatewayを設定する。

Gatewayは共有のNamespaceに配置し、HTTPRouteはマイクロサービスのある各Namespaceに配置する。

apiVersion: gateway.networking.k8s.io/v1

kind: HTTPRoute

metadata:

name: foo

spec:

parentRefs:

- name: ingress-nginx

namespace: ingress-nginx

apiVersion: gateway.networking.k8s.io/v1

kind: HTTPRoute

metadata:

name: foo

spec:

parentRefs:

- name: istio-ingressgateway

namespace: istio-ingress

rules¶

宛先のServiceを設定する。

apiVersion: gateway.networking.k8s.io/v1

kind: HTTPRoute

metadata:

name: foo

spec:

rules:

- backendRefs:

- kind: Service

name: foo

port: 80

HorizontalPodAutoscaler¶

.spec.maxReplicas、spec.minReplicas¶

▼ maxReplicasとは¶

自動水平スケーリングのスケールアウト時の最大Pod数を設定する。

最初、Deploymentの spec.replicas キーに合わせてPodが作成され、次にHorizontalPodAutoscalerの .spec.minReplicas キーが優先される。

この挙動は混乱につながるため、HorizontalPodAutoscalerを使用する場合、Deploymentの spec.replicas キーの設定を削除しておくことが推奨である。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

maxReplicas: 5

▼ minReplicasとは¶

自動水平スケーリングのスケールイン時の最小Pod数を設定する。

最初、Deploymentの spec.replicas キーに合わせてPodが作成され、次にHorizontalPodAutoscalerの .spec.minReplicas キーが優先される。

この挙動は混乱につながるため、HorizontalPodAutoscalerを使用する場合、Deploymentの spec.replicas キーの設定を削除しておくことが推奨である。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

minReplicas: 3

.spec.targetCPUUtilizationPercentage¶

維持するCPU使用率を設定する。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

targetCPUUtilizationPercentage: 50

.spec.metrics¶

▼ metricsとは¶

自動水平スケーリングのトリガーとするメトリクスと、維持されるターゲット値を設定する。

▼ type¶

メトリクスの種類を設定する。

以下のタイプを設定できる。

なお、カスタムメトリクスの元になるデータポイントを収集するためには、別途ツール (例:prometheus-adapter) が必要である。

| タイプ名 | 説明 | メトリクス例 |

|---|---|---|

Resource |

リソースメトリクス | CPU使用率、メモリ使用率など |

Pods |

Podのカスタムメトリクス | Queries Per Second、message broker’s queueなど |

Object |

Pod以外のKubernetesリソースのカスタムメトリクス | Ingressに関するメトリクスなど |

External |

Kubernetes以外の任意のメトリクス | AWS、Google Cloud、Azureに固有のメトリクス |

▼ Resourceの場合¶

Deploymentのリソースメトリクスを指定する。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

metrics:

- type: Resource

resource:

name: cpu

targetAverageUtilization: 60

▼ Podsの場合¶

Podのカスタムメトリクスを指定する。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

metrics:

- type: Pods

resource:

name: cpu

targetAverageUtilization: 60

▼ Objectの場合¶

記入中...

▼ Externalの場合¶

記入中...

.spec.scaleTargetRef¶

▼ scaleTargetRefとは¶

自動水平スケーリングを実行するKubernetesリソースを設定する。

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: foo-horizontal-pod-autoscaler

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment # Deploymentで自動水平スケーリングを実行する。

name: foo-deployment

▼ Deploymentの場合¶

デプロイ戦略に基づいて、新しいReplicaSetを作成し、Podを自動水平スケーリングする。

▼ ReplicaSetの場合¶

既存のReplicaSet配下でPodを自動水平スケーリングする。

▼ StatefulSetの場合¶

デプロイ戦略に基づいて、新しいPodを自動水平スケーリングする。

Ingress¶

.metadata.annotations¶

▼ annotationsとは¶

IngressClassの専用オプションを設定する。

.spec.ingressClassName¶

▼ ingressClassNameとは¶

IngressClassの .metadata.name キーの値を設定する。

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

ingressClassName: foo-ingress-class

.spec.hosts¶

▼ hosts¶

ルーティング条件とするHostヘッダー値を設定する。

.spec.rules[*].hosts キーを設定しなければ、全てのHostヘッダー値が対象になる。

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

hosts: foo.example.com

.spec.rules¶

▼ rulesとは¶

Serviceへのルーティングルールを設定する。

複数のServiceにインバウンド通信を振り分けられる。

Ingressを使用する場合、宛先のServiceは、ClusterIP Serviceとする。

▼ .spec.rules[*].host¶

ホストベースルーティングの判定に使用するパス名を設定する。

本番環境では、ドメインを指定した各種ダッシュボードにリクエストを送信できる必要がある。

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

rules:

- host:

- prd.monitoring.com

http:

paths:

- path: /

▼ .spec.rules[].http.paths[].path¶

パスベースルーティングの判定に使用するパス名を設定する。

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

rules:

- http:

paths:

- path: /foo

- http:

paths:

- path: /bar

▼ .spec.rules[].http.paths[].pathType¶

パスベースルーティング判定時のルールの厳しさを設定する。

| 厳しさ | タイプ | |

|---|---|---|

| パス名の前方一致 | Prefix | 前方一致である。最初のパスさえ合致すれば、トレイリングスラッシュの有無や最初のパス以降のパスも許容して合致させる。そのため、ワイルドカード (*) は不要である。 |

| パス名の完全一致 | Exact | 完全一致である。指定したパスのみを合致させ、トレイリングスラッシュも有無も許容しない。 |

| IngressClassの機能による | ImplementationSpecific | IngressClass (例:Nginx、ALBなど) の設定に応じて、独自タイプ、Prefix、Exactを自動的に切り替える。そのため、IngressのルーティングルールがIngressClassに依存している。IngressClassの仕様変更や別のIngressClassへの移行があった場合に、Ingress Controllerが想定外のルーティングを実行する可能性がある。 |

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

rules:

- http:

paths:

- path: /foo

pathType: Prefix

- http:

paths:

- path: /bar

pathType: Prefix

▼ .spec.rules[].http.paths[].backend¶

宛先のServiceを設定する。

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: foo-ingress

spec:

rules:

- http:

paths:

- path: /foo

pathType: Prefix

backend:

service:

name: foo-service # CluserIP Serviceとする。

port:

number: 80

- http:

paths:

- path: /bar

pathType: Prefix

backend:

service:

name: bar-service # CluserIP Serviceとする。

port:

number: 80

IngressClass¶

.metadata.annotations¶

▼ is-default-class¶

デフォルトのIngressClassとして設定する。

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: foo-ingress-class

annotations:

ingressclass.kubernetes.io/is-default-class: true

spec: ...

.spec.controller¶

▼ controllerとは¶

Ingress Controllerの実体として使用するツールのAPIグループを設定する。

- https://kubernetes.io/docs/reference/kubernetes-api/service-resources/ingress-class-v1/#IngressClassSpec

- https://kubernetes-sigs.github.io/aws-load-balancer-controller/v2.2/guide/ingress/ingress_class/#deprecated-kubernetesioingressclass-annotation

- https://kubernetes.github.io/ingress-nginx/#i-have-only-one-ingress-controller-in-my-cluster-what-should-i-do

▼ AWS ALBの場合¶

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: foo-alb-ingress-class

spec:

controller: ingress.k8s.aws/alb

▼ Nginx Ingressの場合¶

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: foo-ingress-class

spec:

controller: k8s.io/ingress-nginx

▼ Istio Ingressの場合¶

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: foo-istio-ingress-class

spec:

controller: istio.io/ingress-controller

.spec.parameters¶

▼ parametersとは¶

外部Ingressに応じたオプションを設定する。

代わりに、IngressClassParamsを使用しても良い。

▼ AWS ALBの場合¶

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: foo-alb-ingress-class

spec:

parameters:

apiGroup: elbv2.k8s.aws

kind: IngressClassParams

name: foo-alb-ingress-class-params

Gateway¶

spec.gatewayClassName¶

▼ gatewayClassNameとは¶

GatewayClassの .metadata.name キーの値を設定する。

Gatewayは共有のNamespaceに配置し、HTTPRouteはマイクロサービスのある各Namespaceに配置する。

▼ Nginxの場合¶

Nginxを作成する。

apiVersion: gateway.networking.k8s.io/v1

kind: Gateway

metadata:

name: gateway

namespace: istio-ingress

spec:

gatewayClassName: istio

▼ istioの場合¶

Istio Ingress Gatewayを作成する。

apiVersion: gateway.networking.k8s.io/v1

kind: Gateway

metadata:

name: gateway

namespace: istio-ingress

spec:

gatewayClassName: istio

▼ istio-waypointの場合¶

Istioのwaypoint-proxyを作成する。

apiVersion: gateway.networking.k8s.io/v1

kind: Gateway

metadata:

name: gateway

namespace: istio-ingress

spec:

gatewayClassName: istio-waypoint

spec.listeners¶

apiVersion: gateway.networking.k8s.io/v1

kind: Gateway

metadata:

name: gateway

namespace: istio-ingress

spec:

# Istio Ingress Gatewayを作成する

gatewayClassName: istio

listeners:

- name: default

hostname: "*.example.com"

port: 443

protocol: HTTPS

tls:

certificateRefs:

- kind: Secret

group: ""

name: self-signed-cert

namespace: istio-ingress

allowedRoutes:

namespaces:

from: All

GatewayClass¶

spec.controllerName¶

▼ controllerNameとは¶

Gatewayの実体として使用するツールのAPIグループを設定する。

kind: GatewayClass

metadata:

name: foo-gateway

spec:

controllerName: "example.net/gateway-controller"

▼ Envoyの場合¶

apiVersion: gateway.networking.k8s.io/v1

kind: GatewayClass

metadata:

name: envoy-gateway

spec:

controllerName: gateway.envoyproxy.io/gatewayclass-controller

▼ Istioの場合¶

apiVersion: gateway.networking.k8s.io/v1

kind: GatewayClass

metadata:

name: istio

spec:

controllerName: istio.io/gateway-controller

▼ Traefikの場合¶

記入中...

▼ AWS VPC Latticeの場合¶

AWS VPC Latticeをプロビジョニングする。

apiVersion: gateway.networking.k8s.io/v1

kind: GatewayClass

metadata:

name: amazon-vpc-lattice

spec:

controllerName: application-networking.k8s.aws/gateway-api-controller

Namespace¶

apiVersion: v1

kind: Namespace

metadata:

name: foo

NetworkPolicy¶

NetworkPolicyとは¶

自身の所属するNamespaceに対して、インバウンドとアウトバウンドな通信を制限する。

それぞれのNamespaceでNetworkPolicyを作成すると、Namespace間の通信はデフォルトで拒否になる。

そのため、許可するように設定する。

egress¶

許可するアウトバウンド通信を設定する。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: foo-network-policy

namespace: foo

spec:

policyTypes:

- Egress

egress:

# アウトバウンド通信の宛先IPアドレス

- to:

# 送信を許可するCIDRブロック

- ipBlock:

cidr: 10.0.0.0/24

# アウトバウンド通信の宛先ポート

ports:

- protocol: TCP

port: 5978

ingress¶

許可するインバウンド通信を設定する。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: foo-network-policy

namespace: foo

spec:

policyTypes:

- Ingress

ingress:

# インバウンド通信の送信元IPアドレス

- from:

# Cluster外からのインバウンド通信のうちで、受信を許可するCIDRブロック

- ipBlock:

cidr: 172.17.0.0/16

except:

- 172.17.1.0/24

# 受信を許可するNamespace

- namespaceSelector:

matchLabels:

project: myproject

# 同じNamespaceに所属するPodからのインバウンド通信のうちで、受信を許可するPod

- podSelector:

matchLabels:

role: frontend

# インバウンド通信の宛先ポート

- ports:

- protocol: TCP

port: 6379

podSelector¶

▼ podSelectorとは¶

NetworkPolicyを適用するPodを設定する。

▼ matchLabels¶

metadata.labels キーの値でPodを選ぶ。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: foo-network-policy

namespace: foo

spec:

podSelector:

matchLabels:

name: app

▼ 空¶

空 ({}) を設定し、いずれのPodも許可の対象としない。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: foo-network-policy

namespace: foo

spec:

# 全てのPodを拒否する

podSelector: {}

policyTypes:

- Ingress

- Egress

policyTypes¶

許否ルールを適用する通信タイプを設定する。

デフォルト値は Ingress タイプが設定される。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: foo-network-policy

namespace: foo

spec:

policyTypes:

# インバウンド通信に適用する

- Ingress

# アウトバウンド通信に適用する

- Egress

Job¶

.spec.activeDeadlineSeconds¶

▼ activeDeadlineSecondsとは¶

Jobの試行の上限実行時間を設定する。

設定された時間を超過すると、エラーが返却される。

.spec.backoffLimit キーよりも優先される。

apiVersion: batch/v1

kind: Job

metadata:

name: foo-job

spec:

activeDeadlineSeconds: 20

.spec.backoffLimit¶

▼ backoffLimitとは¶

Jobの試行の上限数を設定する。

apiVersion: batch/v1

kind: Job

metadata:

name: foo-job

spec:

backoffLimit: 4

.spec.parallelism¶

▼ parallelismとは¶

同時に起動できるPod数を設定する。

apiVersion: batch/v1

kind: Job

metadata:

name: foo-job

spec:

parallelism: 3

.spec.template¶

▼ templateとは¶

起動するPodを設定する。

apiVersion: batch/v1

kind: Job

metadata:

name: foo-job

spec:

template:

spec:

containers:

- name: foo-alpine

image: alpine:latest

command:

- /bin/bash

- -c

args:

- echo Hello World

restartPolicy: OnFailure

nodeSelector:

node.kubernetes.io/nodetype: foo

.spec.ttlSecondsAfterFinished¶

▼ ttlSecondsAfterFinishedとは¶

Jobが成功/失敗した場合のJob自体の削除を有効化しつつ、その秒数を設定する。

失敗したJobが残り続けると、データポイント収集ツール (例:Prometheus) でメトリクスが記録され続け、アラートを送信し続けてしまう。

そのため、できるだけJobは削除したほうが良い。

apiVersion: batch/v1

kind: Job

metadata:

name: foo-job

spec:

# Job自体の削除を有効化しつつ、Jobの実行が終了してから30秒後とする

ttlSecondsAfterFinished: 30

- https://kubernetes.io/docs/concepts/workloads/controllers/job/#clean-up-finished-jobs-automatically

- https://dev.appswingby.com/kubernetes/kubernetes-%E3%81%A7-job%E3%82%92%E8%87%AA%E5%8B%95%E5%89%8A%E9%99%A4%E3%81%99%E3%82%8Bttlsecondsafterfinished%E3%81%8Cv1-21%E3%81%A7beta%E3%81%AB%E3%81%AA%E3%81%A3%E3%81%A6%E3%81%84%E3%81%9F%E4%BB%B6/

Node¶

Kubernetesの実行時に自動的に作成される。

もし手動で作成する場合は、kubectl コマンドを実行することにより、その時に --register-node キーを false とする必要がある。

LimitRange¶

.spec.limit¶

▼ Containerの場合¶

Namespace内のコンテナのハードウェアリソースの上限必要サイズを設定する。

Podの .spec.containers[*].resources キー配下に設定がなくとも、コンテナの実行時に自動的に挿入できる。

apiVersion: v1

kind: LimitRange

metadata:

name: foo-limit-range

namespace: foo

spec:

limits:

- max:

cpu: "500m"

min:

cpu: "200m"

type: Container

PersistentVolume¶

.spec.accessModes¶

▼ accessModesとは¶

ボリュームへの認可スコープを設定する。

▼ ReadWriteMany¶

ボリュームに対して、複数のNodeから読み出し/書き込み可能にする。

Node間でDBを共有したい場合に使用する。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

accessModes:

- ReadWriteMany

▼ ReadOnlyMany¶

ボリュームに対して、複数のNodeから読み出しでき、また単一のNodeのみから書き込み可能にする。

Node間で読み出し処理のみDBを共有したい場合に使用する。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

accessModes:

- ReadOnlyMany

▼ ReadWriteOnce¶

ボリュームに対して、単一のNodeからのみ読み出し/書き込み可能にする。

もしNodeにPodのインスタンスが複数ある場合、ReadWriteOnce であっても複数のPodから読み込み/書き込みがある。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

accessModes:

- ReadWriteOnce

.spec.capacity¶

▼ capacityとは¶

ストレージの最大サイズを設定する。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

capacity:

storage: 10G

.spec.hostPath¶

▼ hostPathとは¶

PersistentVolumeの一種であるHostPath Volumeを作成する。

Volumeの一種であるPodによるHostPath Volumeとは区別すること。

▼ path¶

Node側のマウント元のディレクトリを設定する。

Podのマウントポイントは、Podの .spec.containers[*].volumeMount キーで設定する。

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

hostPath:

path: /data/src/foo

▼ type¶

マウント方法を設定する。

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

hostPath:

type: DirectoryOrCreate

path: /data/src/foo

.spec.local¶

▼ localとは¶

Node上のストレージにボリュームを作成する。

.spec.nodeAffinity キーの設定が必須であり、Nodeを明示的に指定できる。

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

local:

path: /data/src/foo

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- foo-node

.spec.mountOptions¶

▼ mountOptionsとは¶

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

mountOptions:

- hard

.spec.nfs¶

▼ nfsとは¶

ホスト上であらかじめNFSサーバーを起動しておく。

NFSサーバーのストレージ上にボリュームを作成する。

Node内のPodを、ホスト上のNFSサーバーにマウントする。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

nfs:

server: <NFSサーバーのIPアドレス>

path: /data/src/foo

.spec.nodeAffinity¶

▼ nodeAffinityとは¶

PersistentVolumeの作成先とするNodeを設定する。

▼ required.nodeSelectorTerms.matchExpressions¶

作成先のNodeの .metadata.labels キーを指定するための条件 (In、NotIn、Exists) を設定する。

| 設定値 | 条件の説明 |

|---|---|

| In | 指定した metadata.labels キー配下に、指定した値を持つ。 |

| NotIn | 指定した metadata.labels キー配下に、指定した値を持たない。 |

| Exists | 指定した metadata.labels キーを持つ。 |

| DoesNotExists | 指定した metadata.labels キーを持たない。 |

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

local:

path: /data/src/foo

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

# metadata.labelsキー

- key: node.kubernetes.io/nodetype

operator: In

# metadata.labelsキーの値

values:

- bar-group

# 開発環境であれば minikubeを指定する。

# - minikube

.spec.persistentVolumeReclaimPolicy¶

▼ persistentVolumeReclaimPolicyとは¶

PersistentVolumeのライフサイクルを設定する。

▼ Delete¶

PersistentVolumeを指定するPersistentVolumeClaimが削除された場合、PersistentVolumeも自動的に削除する。

クラウドプロバイダーのPersistentVolumeの動的プロビジョニングのために使用することが多い。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

persistentVolumeReclaimPolicy: Delete

▼ Recycle (非推奨)¶

PersistentVolumeを指定するPersistentVolumeClaimが削除された場合、PersistentVolume内のデータのみを削除し、PersistentVolume自体は削除しない。

将来的に廃止予定のため、非推奨。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

persistentVolumeReclaimPolicy: Recycle

▼ Retain¶

PersistentVolumeを指定するPersistentVolumeClaimが削除されたとしても、PersistentVolumeは削除しない。

割り当てから解除されたPersistentVolumeはReleasedステータスになる。

一度、Releasedステータスになると、他のPersistentVolumeClaimからは指定できなくなる。

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

persistentVolumeReclaimPolicy: Retain

.spec.storageClassName¶

▼ storageClassNameとは¶

ストレージクラス名を設定する。

特に、PersistentVolumeClaimがStorageClassに対応するPersistentVolumeを要求するときに役立つ。

例えば、StorageClassに数種類のボリュームタイプ (standard、fast、slow、gp2 など) がある場合に、区別しやすくなる。

PersistentVolumeにストレージクラス名を設定しない場合、これを要求できるのは、同じくストレージクラス名を持たないPersistentVolumeClaimだけである。

注意点として、もし異なるStorageClassNameに変更したい場合は、PersistentVolumeを作成し直す必要がある。

| クラス名 | 説明 |

|---|---|

"" (明示的な空文字) |

PersistentVolumeに対応するStorageClassがない場合 (PersistentVolumeを使用するが、StorageClassは使用しない場合) につける。 |

local |

PersistentVolumeに対応するStorageClassが中速中容量ストレージの場合につける。 |

standard |

PersistentVolumeに対応するStorageClassが中速中容量ストレージの場合につける。 |

fast |

PersistentVolumeに対応するStorageClassが高速小容量ストレージの場合につける。 |

slow |

PersistentVolumeに対応するStorageClassが低速大容量ストレージの場合につける。 |

*実装例*

apiVersion: v1

kind: PersistentVolume

metadata:

name: foo-persistent-volume

spec:

storageClassName: standard

PersistentVolumeClaim¶

.spec.accessModes¶

▼ accessModesとは¶

要求対象のPersistentVolumeのaccessModeを設定する。

*実装例*

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: foo-persistent-volume-claim

spec:

accessModes:

- ReadWriteMany

.spec.resources¶

▼ resourcesとは¶

要求する仮想ハードウェアのKubernetesリソースを設定する。

▼ requests¶

要求対象のPersistentVolumeのrequestsを設定する。

*実装例*

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: foo-persistent-volume-claim

spec:

resources:

requests:

storage: 2Gi

.spec.storageClassName¶

▼ storageClassNameとは¶

要求対象のPersistentVolumeのストレージクラス名を設定する。

これを設定しない場合は、ストレージクラス名が standard のPersistentVolumeを要求する。

注意点として、もし異なるStorageClassNameに変更したい場合は、PersistentVolumeを作成し直す必要がある。

*実装例*

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: foo-persistent-volume-claim

spec:

storageClassName: standard

Pod¶

.spec.affinity¶

▼ affinityとは¶

Podのスケジューリング対象のNodeを設定する。

.spec.tolerations キーとは反対の条件である。

.spec.nodeSelector キーと比較して、より複雑に条件を設定できる。

DeploymentやStatefulでこれを使用する場合は、Podのレプリカそれぞれが独立し、条件に合わせてkube-schedulerがスケジューリングさせる。

- https://kubernetes.io/docs/concepts/scheduling-eviction/assign-pod-node/#node-affinity

- https://www.devopsschool.com/blog/understanding-node-selector-and-node-affinity-in-kubernetes/

- https://hawksnowlog.blogspot.com/2021/03/namespaced-pod-antiaffinity-with-deployment.html#%E7%95%B0%E3%81%AA%E3%82%8B-namespace-%E9%96%93%E3%81%A7-podantiaffinity-%E3%82%92%E4%BD%BF%E3%81%86%E5%A0%B4%E5%90%88

.spec.affinity.nodeAffinity¶

▼ affinity.nodeAffinityとは¶

Nodeの .metadata.labels キーを指定することにより、kube-schedulerがPodをスケジューリングさせるNodeを設定する。

.spec.nodeSelector キーと比較して、より複雑に条件を設定できる。

DeploymentやStatefulでこれを使用する場合は、Podのレプリカそれぞれが独立し、kube-schedulerは条件に合わせてスケジューリングさせる。

複数のNodeに同じ .metadata.labels キーを付与しておき、このNode群をNodeグループと定義すれば、特定のNodeにPodを作成するのみでなくNodeグループ単位でPodをスケジューリングさせられる。

- https://kubernetes.io/docs/concepts/scheduling-eviction/assign-pod-node/#node-affinity

- https://www.devopsschool.com/blog/understanding-node-selector-and-node-affinity-in-kubernetes/

- https://hawksnowlog.blogspot.com/2021/03/namespaced-pod-antiaffinity-with-deployment.html#%E7%95%B0%E3%81%AA%E3%82%8B-namespace-%E9%96%93%E3%81%A7-podantiaffinity-%E3%82%92%E4%BD%BF%E3%81%86%E5%A0%B4%E5%90%88

▼ requiredDuringSchedulingIgnoredDuringExecution (ハード)¶

条件に合致するNodeにのみPodをスケジューリングさせる。

もし条件に合致するNodeがない場合、Podのスケジューリングを待機し続ける。

共通する SchedulingIgnoredDuringExecution の名前の通り、.spec.affinity キーによるスケジューリングの制御は新しく作成されるPodにしか適用できず、すでに実行中のPodには適用できず、再スケジューリングさせないといけない。

Podが削除された後にNodeの .metadata.labels キーの値が変更されたとしても、一度スケジューリングされたPodが .spec.affinity キーの設定で再スケジューリングされることはない。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

nodeAffinity:

# ハードアフィニティ

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

# PodをスケジューリングさせたいNodeのmetadata.labelsキー

# ここでNodeグループのキーを指定しておけば、Nodeグループ単位でスケジューリングさせられる。

- key: node.kubernetes.io/nodetype

operator: In

# 指定した値をキーに持つNodeに、Podをスケジューリングさせる。

values:

- app

▼ preferredDuringSchedulingIgnoredDuringExecution (ソフト)¶

条件に合致するNodeを優先してPodをスケジューリングさせる。

もし条件に合致するNodeがない場合でも、それを許容する。その上で、条件に合致しないNodeへPodをスケジューリングさせる。

条件に合致しないNodeの探索で重みづけルールを設定できる。

共通する SchedulingIgnoredDuringExecution の名前の通り、.spec.affinity キーによるスケジューリングの制御は新しく作成されるPodにしか適用できない。

すでに実行中のPodには適用できず、再スケジューリングさせないといけない。

Podが削除された後にNodeの .metadata.labels キーの値が変更されたとしても、一度スケジューリングされたPodが .spec.affinity キーの設定で再スケジューリングされることはない。

.spec.affinity.podAffinity¶

▼ affinity.podAffinityとは¶

Node内のPodを、.metadata.labels キーで指定することにより、そのPodと同じNode内に、新しいPodをスケジューリングさせる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

podAffinity:

# ハードアフィニティー

requiredDuringSchedulingIgnoredDuringExecution:

# 分散単位

- topologyKey: kubernetes.io/hostname

labelSelector:

- matchExpressions:

# Podのmetadata.labelsキー

- key: app.kubernetes.io/name

operator: In

# 指定した値をキーに持つPodと同じNodeに、Podをスケジューリングさせる。

values:

- bar-gin

preferredDuringSchedulingIgnoredDuringExecutionの場合、podAffinityTerm キーや preference キーが必要である。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

podAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 100

podAffinityTerm:

topologyKey: kubernetes.io/hostname

labelSelector:

- matchExpressions:

- key: app.kubernetes.io/name

operator: In

values:

- bar-gin

▼ requiredDuringSchedulingIgnoredDuringExecution (ハード)¶

.spec.affinity.nodeAffinity キーのPod版である。

▼ preferredDuringSchedulingIgnoredDuringExecution (ソフト)¶

.spec.affinity.nodeAffinity キーのPod版である。

.spec.affinity.podAntiAffinity¶

▼ affinity.podAntiAffinityとは¶

.metadata.labels キーを持つNodeとは異なるNode内に、そのPodをスケジューリングさせる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

podAntiAffinity:

# ハードアフィニティー

requiredDuringSchedulingIgnoredDuringExecution:

# Podの分散単位

- topologyKey: topology.kubernetes.io/zone

labelSelector:

- matchExpressions:

# Podのmetadata.labelsキー

- key: app.kubernetes.io/name

operator: In

# 指定した値をキーに持つPodとは異なるNodeに、Podをスケジューリングさせる。

values:

- bar-gin

preferredDuringSchedulingIgnoredDuringExecutionの場合、podAffinityTerm キーや preference キーが必要である。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

podAntiAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 100

podAffinityTerm:

topologyKey: topology.kubernetes.io/zone

labelSelector:

- matchExpressions:

- key: app.kubernetes.io/name

operator: In

values:

- bar-gin

*スケジューリング例*

もし、コピーするPodの名前を設定した場合、Podのレプリカ同士は同じNodeにスケジューリングされることを避ける。

また、分散単位に topology.kubernetes.io/zone を設定しているため、各AZにPodをバラバラにスケジューリングさせる。

結果として、各AZのNodeにPodが 1 個ずつスケジューリングされるようになる。

apiVersion: apps/v1

kind: Deployment

metadata:

name: foo-deployment

spec:

selector:

matchLabels:

app.kubernetes.io/name: foo-pod

replicas: 3

template:

metadata:

labels:

app.kubernetes.io/name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

affinity:

podAntiAffinity:

# ハードアフィニティー

requiredDuringSchedulingIgnoredDuringExecution:

# Podの分散単位

- topologyKey: topology.kubernetes.io/zone

labelSelector:

- matchExpressions:

# Podのmetadata.labelsキー

- key: app.kubernetes.io/name

operator: In

# 指定した値をキーに持つPodとは異なるNodeに、Podをスケジューリングさせる。

values:

# 自身がコピーするPodの名前

- app

▼ requiredDuringSchedulingIgnoredDuringExecution (ハード)¶

.spec.affinity.nodeAffinity キーのアンチPod版である。

▼ preferredDuringSchedulingIgnoredDuringExecution (ソフト)¶

.spec.affinity.nodeAffinity キーのアンチPod版である。

▼ node affinity conflict¶

ただし、AWSのスポットインスタンスと相性が悪く、特定のAZでしかNodeが作成されなかった場合に、以下のようなエラーになってしまう。

N node(s) had volume node affinity conflict, N node(s) didn't match Pod's node affinity/selector

.spec.containers¶

▼ containersとは¶

Pod内で起動するコンテナを設定する。

PodをDeploymentやReplicaSetに紐付けず、単体で使用することは非推奨である。

▼ name、image¶

Podを構成するコンテナの名前、ベースイメージを設定する。

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

AWS ECRからコンテナイメージをプルする場合は、以下の通りである。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: <AWSアカウントID>.dkr.ecr.ap-northeast-1.amazonaws.com/foo-repository/app:1.0.0

ports:

- containerPort: 8080

▼ env¶

環境変数を設定する。

*実装例*

status.podIP から自身のIPアドレスを取得し、MY_POD_IP という名前で設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

env:

- name: MY_POD_IP

valueFrom:

fieldRef:

apiVersion: v1

fieldPath: status.podIP

▼ envFrom¶

.spec.volumes.secret キー (ファイルをコンテナに設定する) とは異なり、SecretやConfigMapからコンテナに環境変数を出力する。

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

envFrom:

- secretRef:

# 環境変数としてコンテナに出力するSecret

name: foo-secret

- configMapRef:

# 環境変数としてコンテナに出力するConfigMap

name: foo-config-map

▼ ports¶

コンテナが待ち受けるポート番号を、仕様として設定する。

単なる仕様であり、ドキュメントとしての役割がある。

コンテナがポート番号を公開してさえいれば、.spec.containers[*].ports キーは設定しなくとも問題ない。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

# 待ち受けるポート番号の仕様

ports:

# コンテナがポート番号を公開していれば、設定しなくてもポートは公開されている

- containerPort: 8080

▼ imagePullPolicy¶

イメージのプルのルールを設定する。

| オプション | 説明 |

|---|---|

| IfNotPresent | Node上にコンテナイメージのキャッシュがあればこれを使用する。なければイメージリポジトリからぷるする。 |

| Always | Node上のキャッシュを使用せず、常にイメージリポジトリからコンテナイメージをプルする。 |

| Never | Node上にコンテナイメージのキャッシュを常にを使用する。 |

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

imagePullPolicy: IfNotPresent

ports:

- containerPort: 8080

▼ resources.requests、resources.limits¶

Node全体のハードウェアリソースを分母として、Pod内のコンテナが要求するリソースの下限/上限必要サイズを設定する。

各PodはNode内のハードウェアリソース (cpu、memory、ephemeral-storage) を奪い合っており、Nodeが複数ある場合、kube-schedulerは requests 値以上の余剰があるNode上にPodのスケジューリングを実行する。

この時kube-schedulerは、コンテナの resource キーの値に基づいて、どのNodeにPodを作成するかを決めている。

同じPod内に resources キーを設定したコンテナが複数ある場合、下限/上限の必要サイズを満たしているか否かの判定は、同じPod内のコンテナの要求サイズの合計値に基づく。

| キー名 | 説明 | 補足 |

|---|---|---|

requests |

ハードウェアリソースの下限必要サイズを設定する。 | ・高くしすぎると、そのPod内のコンテナがハードウェアリソースを常に要求するため、他のPodがスケーリングしにくくなる。 ・もし、設定値がNodeのハードウェアリソース以上の場合、コンテナは永遠に起動しない。 ・https://qiita.com/jackchuka/items/b82c545a674975e62c04#cpu ・もし、これを設定しない場合は、コンテナが使用できるハードウェアリソースの下限がなくなる。そのため、Kubernetesが重要なPodにリソースを必要最低限しか割かず、性能が低くなる可能性がある。 |

limits |

ハードウェアリソースの上限必要サイズを設定する。 | ・低くしすぎると、コンテナにハードウェアリソースを割り当てられないため、性能が常時悪くなる。 ・もし、コンテナが上限値以上のハードウェアリソースを要求すると、CPUの場合はPodは削除されずに、コンテナのスロットリング (起動と停止を繰り返す) が起こる。一方でメモリの場合は、OOMキラーによってPodのプロセスが削除され、Podは再作成される。 ・https://blog.mosuke.tech/entry/2020/03/31/kubernetes-resource/ ・もし、これを設定しない場合は、コンテナが使用できるハードウェアリソースの上限がなくなる。そのため、Kubernetesが重要でないPodにリソースを割いてしまう可能性がある。 ・https://kubernetes.io/docs/tasks/configure-pod-container/assign-cpu-resource/#if-you-do-not-specify-a-cpu-limit ・https://kubernetes.io/docs/tasks/configure-pod-container/assign-memory-resource/#if-you-do-not-specify-a-memory-limit |

補足として、Node全体のハードウェアリソースは、kubectl describe コマンドから確認できる。

$ kubectl describe node <Node名>

...

Capacity:

attachable-volumes-aws-ebs: 20

cpu: 4 # NodeのCPU

ephemeral-storage: 123456789Ki

hugepages-1Gi: 0

hugepages-2Mi: 0

memory: 1234567Ki # Nodeのメモリー

pods: 10 # スケジューリング可能なPodの最大数

Allocatable:

attachable-volumes-aws-ebs: 20

cpu: 3920m # 実際に使用可能なCPU

ephemeral-storage: 123456789

hugepages-1Gi: 0

hugepages-2Mi: 0

memory: 1234567Ki # 実際に使用可能なメモリ

pods: 10

...

▼ resources.requests/limits.<ハードウェアリソース>¶

| ハードウェアリソース名 | 単位 | |

|---|---|---|

cpu |

コンテナのCPU | m:millicores (1m = 1 ユニット = 0.001 コア) |

memory |

コンテナのメモリ | Mi:mebibyte (1Mi = 1.04858MB) |

ephemeral-storage |

EmptyDir Volume、ログ、ローカルディスクへの書き込み | Mi:mebibyte |

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

resources:

# 下限必要サイズ

requests:

cpu: 250m

ephemeral-storage: 500Mi

memory: 64Mi

# 上限サイズ

limits:

cpu: 500m

ephemeral-storage: 2Gi

memory: 512Mi

- name: istio-proxy

...

各コンテナの実際のハードウェアリソース消費量を確認する場合は、kubectl top コマンドを使用する。

『(実測値) ÷ (メモリ上限値) × 100』で計算できる。

$ kubectl top pod --container -n foo-namespace

POD NAME CPU(cores) MEMORY(bytes)

foo-pod app 1m 19Mi # 19Mi ÷ 128Mi × 100 = 14%

foo-pod istio-proxy 5m 85Mi

▼ volumeMounts¶

Pod内のコンテナのマウントポイントを設定する。

パスは相対パスではなく絶対パスで指定する。

.spec.volumes キーで設定されたボリュームのうちから、コンテナにマウントするボリュームを設定する。

Node側のマウント元のディレクトリは、PersistentVolumeの .spec.hostPath キーで設定する。

volumeMountという名前であるが、『ボリュームマウント』を実行するわけではなく、VolumeやPersistentVolumeで設定された任意のマウントを実行できることに注意する。

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

volumeMounts:

- name: app-volume

# 絶対パスにする

mountPath: /go/src

volumes:

- name: app-volume

persistentVolumeClaim:

claimName: foo-persistent-volume-claim

*実装例*

Secretの名前を指定できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

volumeMounts:

- name: app-volume

# 絶対パスにする

mountPath: /go/src

volumes:

- name: app-volume

secret:

secretName: app-secret

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

# 資格情報ファイルをマウントする

volumeMounts:

- name: credentials-volume

# 絶対パスにする

mountPath: /credentials

env:

# Google Cloudの資格情報のパスを設定する

- name: GOOGLE_APPLICATION_CREDENTIALS

value: /credentials/google_cloud_credentials.json

volumes:

- name: credentials-volume

secret:

secretName: app-secret

---

apiVersion: v1

kind: Secret

metadata:

name: app-secret

type: Opaque

data:

google_cloud_credentials.json: *****

▼ workingDir¶

コンテナの作業ディレクトリを設定する。

ただし、作業ディレクトリの設定はアプリケーション側の責務のため、Kubernetesで設定するよりもDockerfileで定義したほうが良い。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

workingDir: /go/src

.spec.containers[*].livenessProbe¶

▼ livenessProbeとは¶

kubeletがヘルスチェックを実行することで、コンテナが正常に動作しているか確認する。

注意点として、LivenessProbeヘルスチェックの間隔が短すぎると、kubeletに必要以上の負荷がかかる。

terminationGracePeriodSeconds に関しては、.spec.terminationGracePeriodSeconds キーでPod単位での待機時間を設定できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-app-springboot

image: foo-app-springboot:1.0.0

livenessProbe:

httpGet:

port: 8080

# SpringBoot製Javaアプリケーションのlivenessエンドポイント

path: /actuator/health/liveness

scheme: HTTP

# 各設定のデフォルト値を示す

initialDelaySeconds: 0

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationGracePeriodSeconds: 30

terminationGracePeriodSeconds: 30

▼ exec¶

コンテナのLivenessProbeヘルスチェックで、任意のコマンドによるヘルスチェックを実行する。

終了コード 0 なら成功である。

LivenessProbeが対応可能なプロトコル (HTTP、TCP、gRPCによるHTTP) 以外で、ヘルスチェックを実行したい場合に役立つ。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

exec:

command:

- source

- healthcheck.sh

▼ httpGet¶

コンテナのLivenessProbeヘルスチェックで、L7 チェックを実行する。

200 ステータスから 399 ステータスまでの間なら成功である。

具体的には、コンテナの指定したエンドポイントにGETメソッドでHTTPリクエストを送信し、レスポンスのステータスコードを検証する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

httpGet:

port: 80

path: /healthcheck

# またはHTTPS

scheme: HTTP

自身のアプリケーションではエンドポイントを実装する必要があるが、OSSではすでに用意されていることが多い。

| ツール | エンドポイント |

|---|---|

| Alertmaanger | /-/healthy |

| Grafana | /healthz |

| Kiali | /kiali/healthz |

| Prometheus | /-/healthy |

| ... | ... |

▼ failureThreshold¶

デフォルト値は 3 である。

コンテナのLivenessProbeヘルスチェックが失敗したとみなす試行回数を設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

failureThreshold: 5

▼ initialDelaySecond¶

デフォルト値は 0 である。

初回のLivenessProbeヘルスチェックを開始するまでの待機時間を設定する。

この時間を過ぎてもコンテナのLivenessProbeヘルスチェックが失敗する場合、Podはコンテナを再起動する。

設定した時間が短すぎると、Podがコンテナの起動を待てずに再起動を繰り返してしまう (デフォルト値の 0 は短すぎる) 。

一方で、設定した時間が長すぎると、Podの作成開始から完了まで時間がかかりすぎてしまう。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

# 初回以降のLivenessProbeヘルスチェックを実行するまでに5秒間待機する。

initialDelaySeconds: 10

▼ periodSeconds¶

デフォルト値は 10 である。

コンテナのLivenessProbeヘルスチェックの試行当たりの間隔を設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

# 5秒ごとにLivenessProbeヘルスチェックを実行する。

periodSeconds: 5

▼ successThreshold¶

デフォルト値は 1 である。

LivenessProbeヘルスチェックの失敗後のリトライで、成功と判定する最小試行回数を設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

successThreshold: 1

▼ tcpSocket¶

コンテナのLivenessProbeヘルスチェックで、L4 チェックを実行する。

具体的には、コンテナにTCPスリーウェイハンドシェイクを実行し、TCP接続を確立できるかを検証する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

tcpSocket:

port: 8080

▼ terminationGracePeriodSeconds¶

デフォルト値はPod単位の .spec.terminationGracePeriodSeconds キーを継承し、30 である。

コンテナの終了プロセスを開始するまで待機時間を設定する。

この時間を超えてもコンテナを終了できていない場合は、コンテナを強制的に停止する。

設定した時間が長すぎると、Pod全体の終了プロセスに時間がかかり、Podの削除までに時間がかかりすぎてしまう。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

terminationGracePeriodSeconds: 10

terminationGracePeriodSeconds: 45

▼ timeoutSeconds¶

デフォルト値は 1 である。

コンテナのLivenessProbeヘルスチェックのタイムアウト時間を設定する。

この時間を過ぎてもコンテナのLivenessProbeヘルスチェックが失敗する場合、Podはコンテナを再起動する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

livenessProbe:

# LivenessProbeヘルスチェックのタイムアウト時間を30秒とする。

timeoutSeconds: 10

.spec.containers[*].startupProbe¶

▼ startupProbeとは¶

kubeletがヘルスチェックを実行することで、アプリケーションの起動が完了したかを確認する。

ReadinessProbeよりも先に実行される。

言語やフレームワークによってはStartupProbe用のエンドポイントが提供されていない場合があり、ReadinessProbe用のエンドポイントで代用する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-app-springboot

image: foo-app-springboot:1.0.0

startupProbe:

httpGet:

port: 8080

# SpringBoot製Javaアプリケーションののstartupエンドポイント

path: /actuator/startup

initialDelaySeconds: 10

periodSeconds: 10

timeoutSeconds: 10

successThreshold: 1

failureThreshold: 5

terminationGracePeriodSeconds: 10

.spec.containers[*].readinessProbe¶

▼ readinessProbeとは¶

kubeletがヘルスチェックを実行することで、コンテナがトラフィックを処理可能かを確認する。

terminationGracePeriodSeconds に関しては、.spec.terminationGracePeriodSeconds キーでPod単位での待機時間を設定できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-app-springboot

image: foo-app-springboot:1.0.0

readinessProbe:

httpGet:

port: 8080

# SpringBoot製JavaアプリケーションのReadinessエンドポイント

path: /actuator/health/readiness

scheme: HTTP

# 各設定のデフォルト値を示す

initialDelaySeconds: 0

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationGracePeriodSeconds: 30

terminationGracePeriodSeconds: 30

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-app-grpc

image: foo-app-grpc:1.0.0

readinessProbe:

tcpSocket:

port: 5000

# 各設定のデフォルト値を示す

initialDelaySeconds: 0

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationGracePeriodSeconds: 30

terminationGracePeriodSeconds: 30

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-app-grpc

image: foo-app-grpc:1.0.0

readinessProbe:

grpc:

port: 8080

# 各設定のデフォルト値を示す

initialDelaySeconds: 0

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationGracePeriodSeconds: 30

terminationGracePeriodSeconds: 30

コンテナが起動してもトラフィックを処理できるようになるまで時間がかかる場合や、問題の起きたコンテナへトラフィックを流さない場合に役立つ。例えば、Javaのウォームアップ完了まで、Nginxの最初の設定ファイル読み込み完了まで、MySQLの最初の接続受信準備完了までなどである。

注意点として、ReadinessProbeの間隔が短すぎると、kubeletに必要以上の負荷がかかる。

そのため、READY は 0 で、STATUS は Running になる。

$ kubectl get pod -n foo-namespace

NAME READY STATUS RESTARTS AGE

foo-pod 0/1 Running 0 14m

bar-pod 0/1 Running 0 14m

Readiness probe failed: Get "http://*.*.*.*:*/ready": dial tcp *.*.*.*:*: connect: connection refused

- https://www.ianlewis.org/jp/kubernetes-health-check

- https://amateur-engineer-blog.com/livenessprobe-readinessprobe/#toc4

- https://kodekloud.com/community/t/what-is-the-meaning-for-a-pod-with-ready-0-1-and-state-running/21660

- https://spring.io/blog/2020/03/25/liveness-and-readiness-probes-with-spring-boot

▼ exec¶

コンテナのLivenessProbeヘルスチェックで、任意のコマンドのヘルスチェックを実行する。

終了コード 0 なら成功である。

LivenessProbeが対応可能なプロトコル (HTTP、TCP、gRPCによるHTTP) 以外で、ヘルスチェックを実行したい場合に役立つ。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

exec:

command:

- source

- healthcheck.sh

▼ httpGet¶

コンテナのReadinessProbeヘルスチェックで、L7 チェックを実行する。

200 ステータスから 399 ステータスまでの間なら成功である。

具体的には、コンテナの指定したエンドポイントにGETメソッドでHTTPリクエストを送信し、レスポンスのステータスコードを検証する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

httpGet:

port: 80

path: /healthcheck

# またはHTTPS

scheme: HTTP

▼ failureThreshold¶

デフォルト値は 3 である。

ReadinessProbeヘルスチェックが失敗したとみなす試行回数を設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

failureThreshold: 5

▼ initialDelaySeconds¶

デフォルト値は 0 である。

初回のReadinessProbeヘルスチェックを開始するまでの待機時間を設定する。

この時間を過ぎてもコンテナのReadinessProbeヘルスチェックが失敗する場合、Podはコンテナを再起動する。

設定した時間が短すぎると、Podがコンテナの起動を待てずに再起動を繰り返してしまう (デフォルト値の 0 は短すぎる) 。

一方で、設定した時間が長すぎると、Podの作成開始から完了まで時間(つまり、リリースの作業時間)がかかりすぎてしまう。

例えば、gRPCサーバーであれば基本的には 1 秒以内で起動するため、initialDelaySeconds は 5 ほどでよい。

Workloadを何度かリスタートし、問題なく起動できれば調整は完了である。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

initialDelaySeconds: 10

▼ periodSeconds¶

デフォルト値は 10 である。

ReadinessProbeヘルスチェックの試行当たりの間隔を設定する。

適正値は 10 秒ほどで良い。

Workloadを何度かリスタートし、問題なく起動できれば調整は完了である。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

periodSeconds: 5

▼ successThreshold¶

デフォルト値は 1 である。

ReadinessProbeヘルスチェックの失敗後のリトライで、成功と判定する最小試行回数を設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

successThreshold: 1

▼ tcpSocket¶

ReadinessProbeヘルスチェックで、L4 チェックを実行する。

コンテナにTCPスリーウェイハンドシェイクを実行し、TCP接続を確立できるかを検証する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

tcpSocket:

port: 3306

▼ terminationGracePeriodSeconds¶

デフォルト値はPod単位の .spec.terminationGracePeriodSeconds キーを継承し、30 である。

コンテナの終了プロセスを開始するまで待機時間を設定する。

この時間を超えてもPodを終了できていない場合は、コンテナを強制的に停止する。

設定した時間が長すぎると、Pod全体の終了プロセスに時間がかかり、Podの削除までに時間がかかりすぎてしまう。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

terminationGracePeriodSeconds: 10

terminationGracePeriodSeconds: 45

▼ timeoutSeconds¶

デフォルト値は 1 である。

コンテナのReadinessProbeヘルスチェックのタイムアウト時間を設定する。

この時間を過ぎてもコンテナのReadinessProbeヘルスチェックが失敗する場合、Podはコンテナを再起動する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

readinessProbe:

# ReadinessProbeヘルスチェックのタイムアウト時間を30秒とする。

timeoutSeconds: 10

.spec.containers[*].securityContext¶

▼ securityContextとは¶

Pod内の特定のコンテナに対して、認可スコープを設定する。

オプションは、.spec.securityContext キーと同じである。

.spec.containers[*].volumeMounts¶

▼ volumeMountsとは¶

PodのVolume内のディレクトリをコンテナにマウントする。

パスは相対パスではなく絶対パスで指定する。

▼ subPath¶

PodのVolume内のサブディレクトリを指定し、マウント可能にする。

これを指定しない場合、Volumeのルートディレクトリ配下をコンテナへマウントすることになる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

volumeMounts:

- name: app-volume

# foo-volumeにあるwwwディレクトリを指定する

subPath: www

# コンテナのvarディレクトリをマウントする

mountPath: /var

volumes:

- name: app-volume

emptyDir: {}

ディレクトリではなく、ファイルを指定できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

volumeMounts:

- name: app-volume

# foo-volumeにあるwww.confファイルを指定する

subPath: www.conf

# コンテナに/etc/www.confファイルとしてマウントする

mountPath: /etc/www.conf

volumes:

- name: app-volume

emptyDir: {}

.spec.enableServiceLinks¶

▼ enableServiceLinks¶

Serviceの宛先情報 (IPアドレス、プロトコル、ポート番号) に関する環境変数をPod内に出力するかどうかを設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

enableServiceLinks: false

.spec.hostname¶

▼ hostnameとは¶

Podのホスト名を設定する。

また、.spec.hostname キーが設定されていないときは、.metadata.name がホスト名として使用される。

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

hostname: foo-pod

.spec.hostNetwork¶

▼ hostNetworkとは¶

Podが、自身の稼働するNodeのネットワークにリクエストを送信できるかどうかを設定する。

ユーザーが使用するうユースケースは少なく、例えばNode ExporterのPodで使用される。

apiVersion: v1

kind: Pod

metadata:

name: foo-node-exporter

spec:

containers:

- name: foo-node-exporter

image: prom/node-exporter:1.0.0

hostNetwork: true

.spec.imagePullSecrets¶

▼ imagePullSecretsとは¶

プライベートイメージリポジトリからコンテナイメージをプルするため、プライベートイメージリポジトリの資格情報を持つSecretを設定する。

別途、ServiceAccountの .imagePullSecrets キーでも同じSecretを指定しておき、このServiceAccountをPodに紐付ける。

これにより、PodはSecretにあるプライベートリポジトリの資格情報を使用できるようになる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: private-app:1.0.0 # プライベートプライベートイメージリポジトリ

imagePullSecrets:

- name: app-repository-credentials-secret # プライベートイメージリポジトリの資格情報を持つSecret

- https://kubernetes.io/docs/concepts/containers/images/#specifying-imagepullsecrets-on-a-pod

- https://kubernetes.io/docs/tasks/configure-pod-container/pull-image-private-registry/#create-a-pod-that-uses-your-secret

- https://medium.com/makotows-blog/kubernetes-private-registry-tips-image-pullsecretse-20dfb808dfc-e20dfb808dfc

.spec.initContainers¶

▼ initContainersとは¶

.spec.containers キーで設定したコンテナよりも先に起動するコンテナ (InitContainer) を設定する。

依存先コンテナ (例:DBコンテナ、インメモリDBコンテナ) の待機処理、依存ツールやサーバー証明書のインストール処理などのために使用する。

▼ command¶

実行するコマンドを設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

volumeMounts:

- name: app-volume

mountPath: /go/src

initContainers:

- name: readiness-check-redis

image: busybox:1.28

# StatefulSetのインメモリDBコンテナの6379番ポートに通信できるまで、本Podのappコンテナの起動開始を待機する。

# StatefulSetでReadinessProbeヘルスチェックを設定しておけば、これのPodがREADYになるまでncコマンドは成功しないようになる。

command:

- /bin/bash

- -c

args:

- |

until nc -z inmemory-db 6379; do

echo waiting for inmemory-db;

sleep 2;

done

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: foo-db

image: redis:8.0

ports:

- containerPort: 6379

volumeMounts:

- name: foo-inmemory-db-volume

mountPath: /var/lib

volumes:

- name: foo-inmemory-db-volume

emptyDir: {}

▼ restartPolicy¶

Always 値を設定することで、サイドカーコンテナを作成できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

ports:

- containerPort: 8080

volumeMounts:

- name: app-volume

mountPath: /go/src

initContainers:

- name: sidecar

image: proxy:1.0.0

restartPolicy: Always

.spec.priorityClassName¶

▼ priorityClassNameとは¶

Podのスケジューリングの優先度を設定する。

何らかの理由 (例:ハードウェアリソース不足など) でより優先度の高いPodをスケジューリングさせられない場合、より優先度の低いPodをNodeから退去させ、優先度の高いPodをスケジューリングさせる。

| 設定値 | 優先度 |

|---|---|

system-node-critical、system-cluster-critical |

最優先 |

high |

|

low-non-preemptible |

|

low |

後回し |

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

priorityClassName: system-node-critical

▼ DaemonSet配下のPod¶

DaemonSet配下のPodは、デフォルトで全てのNodeでスケジューリングされるようになっている。

ただし何らかの理由 (例:ハードウェアリソース不足など) で、特定のNodeでDaemonSet配下のPodをスケジューリングさせられないことがある。

他のPodよりスケジューリングの優先度を上げるために、DaemonSet配下のPodには必ず、system-node-critical のPriorityClassNameを設定しておく。

.spec.nodeSelector¶

▼ nodeSelectorとは¶

Podのスケジューリング対象とするNodeを設定する。

.spec.affinity キーと比較して、より単純に条件を設定できる。

複数のNodeに同じ .metadata.labels キーを付与しておき、このNode群をNodeグループと定義すれば、特定のNodeにPodを作成するのみでなくNodeグループにPodを作成できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

nodeSelector:

node.kubernetes.io/nodetype: foo

▼ DaemonSet配下のPod¶

DaemonSetでは、特定のNodeにPodをスケジューリングさせられる。

▼ nodeSelectorとaffinittyの両方設定¶

.spec.nodeSelector キーと .spec.affinity キーの両方を設定できる。

両方を設定した場合、両方を満たしたNodeにPodをスケジューリングさせられる。

.spec.restartPolicy¶

▼ restartPolicyとは¶

Pod内のコンテナのライフサイクルの再起動ポリシーを設定する。

▼ Always¶

コンテナが停止した場合、これが正常 (終了ステータス 0) か異常 (終了ステータス 1) かを問わず、常にコンテナを再起動する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

restartPolicy: Always

▼ Never¶

コンテナが停止した場合、コンテナを再起動しない。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

restartPolicy: Never

▼ OnFailure¶

コンテナが停止した場合、これが異常 (終了ステータス 1) の場合にのみ、常にコンテナを再起動する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

restartPolicy: OnFailure

.spec.securityContext¶

▼ securityContextとは¶

Pod内の全てのコンテナに対して、認可スコープを設定する。

▼ runAsUser¶

コンテナのプロセスのユーザーIDを設定する。

コンテナがユーザーを提供していない場合、あらじかじめユーザーを作成する必要がある。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

securityContext:

runAsUser: 999

▼ runAsGroup¶

コンテナのプロセスのグループIDを設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

securityContext:

runAsGroup: 3000

▼ runAsNonRoot¶

コンテナを特権モード (root権限) で実行できないようにする。

もしこれを設定したコンテナがroot権限の実行ユーザーを使用しようとすると、コンテナの起動に失敗する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

securityContext:

runAsNonRoot: true

▼ fsGroup¶

Pod内のコンテナ内のファイルに以下を実行する。

- 指定した番号のユーザーグループを作成する

- ファイルのユーザーグループ権限を指定したユーザーグループ番号に設定する

- ファイルのアクセス権限を

0660に設定する

設定しない場合、ボリュームのファイルの権限はrootユーザー (コンテナのデフォルトユーザー) になる。

例えば、999 にすれば、999 というユーザーグループが作成され、999 番グループしかファイルを利用できなくなる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

securityContext:

fsGroup: 999

.spec.serviceAccountName¶

▼ serviceAccountNameとは¶

PodにServiceAccountを紐付ける。

Podのプロセスに認証済みのIDが付与され、Kubernetesと通信できるようになる。

*実装例*

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

serviceAccountName: foo-service-account

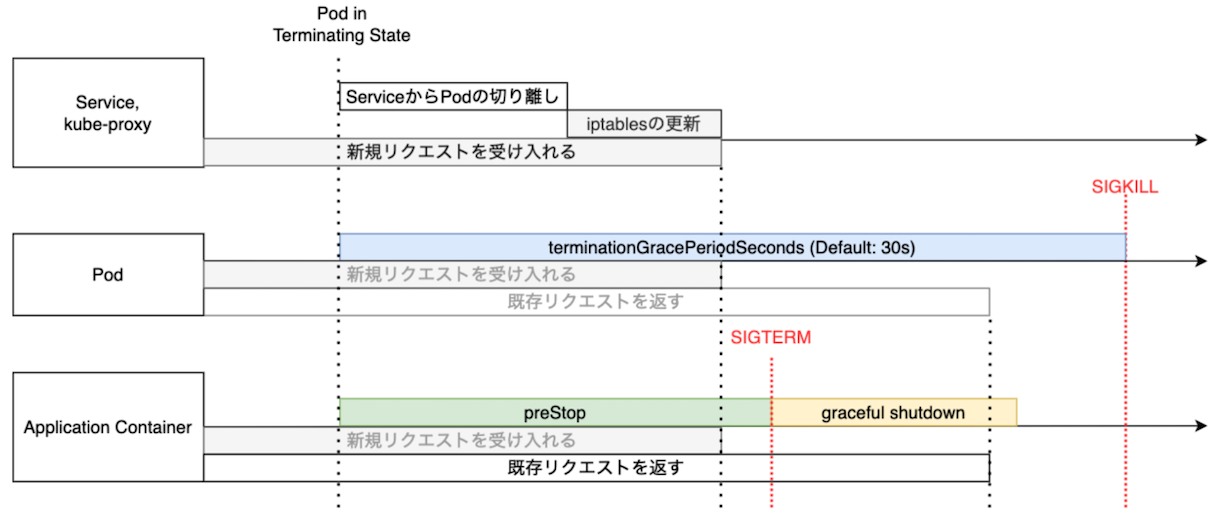

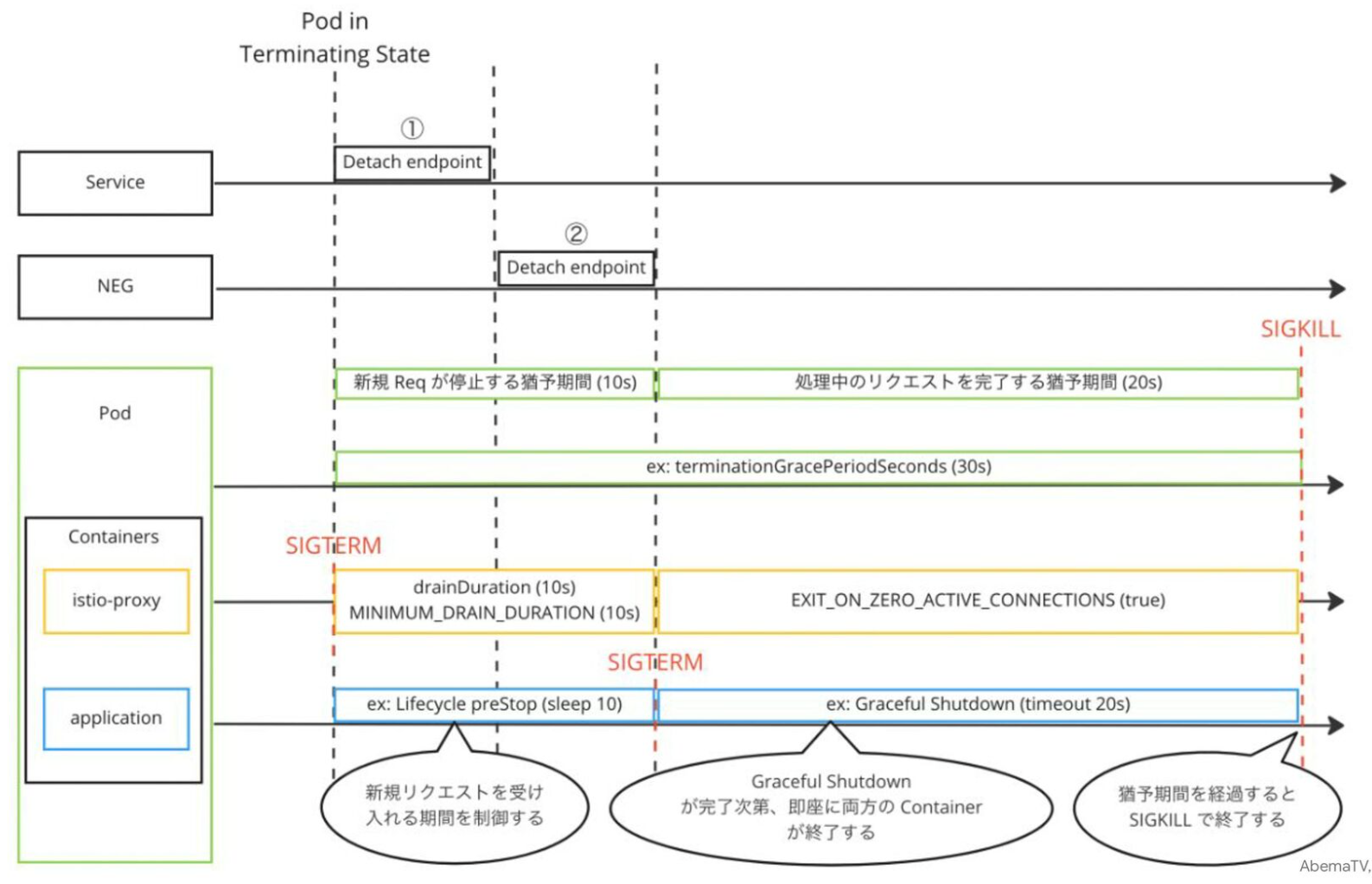

.spec.terminationGracePeriodSeconds¶

▼ terminationGracePeriodSecondsとは¶

Podの終了プロセスを開始するまで待機時間を設定する。

この時間を超えてもPodを終了できていない場合は、コンテナを強制的に停止する。

なお、.spec.containers[*].xxxProbe.terminationGracePeriodSeconds キーでコンテナ単位での待機時間を設定できる。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

terminationGracePeriodSeconds: 45

▼ コンテナが複数個ある場合¶

Pod内にアプリ以外のコンテナ (istio-proxyなど) がある場合、全てのコンテナの終了プロセスの時間を考慮する必要がある。

.spec.tolerations¶

▼ tolerationsとは¶

TaintsとTolerationsを使用すると、指定した条件に合致するPod以外をNodeにスケジューリングさせないようにできる。

例えば、Workloadが少ないNodeグループ (monitoring、ingress など) にTaintを設定し、Workloadが多いNodeグループ (app、system など) にはこれを設定しないようにする。

すると、.spec.tolerations キーを設定しない限り、Podが多いNodeグループの方にPodがスケジューリングされる。

そのため、NodeSelectorやNodeAffinityを使用するより、スケジューリング対象のNodeを設定する手間が省ける。

以下の方法で設定する。

事前にNodeへTaintを設定しておく。

# 非マネージドの場合

$ kubectl taint node foo-node group=monitoring:NoSchedule

# マネージドの場合

# NodeグループやNodeプールで一括してTaintを設定する

Taintへの耐性を .spec.tolerations キーで設定する。

apiVersion: v1

kind: Pod

metadata:

name: prometheus

spec:

containers:

- name: app

image: app:1.0.0

# Taintへの耐性をtolerationsで定義する

tolerations:

- key: <キー>

operator: Equal

value: <値>

effect: <エフェクト>

合致する条件の .spec.tolerations キーを持つPodしか、Taintを持つNodeにスケジューリングさせられない。

.spec.affinity キーとは反対の条件である。

デフォルトでは、PodはNodeの metadata.labels キーを条件としてスケジューリングされる。そのため、kube-schedulerは該当の値を持たないNodeにPodをスケジューリングさせる。

▼ NoSchedule¶

指定した条件に合致するNodeにはスケジューリングさせない。

なお、実行中のPodが違反していた場合でも、再スケジューリングさせない。

*実装例*

kube-system で管理したいような重要なPodに CriticalAddonsOnly キーのTolerationsを設定する。

合わせてNodeのTaintにも CriticalAddonsOnly キーを設定することで、Taintに耐性のあるPod (CriticalAddonsOnly キー) しか、このNodeにスケジューリングできなくなる。

apiVersion: v1

kind: Pod

metadata:

name: foo-coredns

namespace: kube-system

spec:

containers:

- name: coredns

image: coredns

imagePullPolicy: IfNotPresent

# Taintへの耐性をtolerationsで定義する

tolerations:

- key: CriticalAddonsOnly

operator: Exists

*実装例*

$ kubectl taint node foo-node group=monitoring:NoSchedule

apiVersion: v1

kind: Pod

metadata:

name: prometheus

spec:

containers:

- name: prometheus

image: prom/prometheus

imagePullPolicy: IfNotPresent

# Taintへの耐性をtolerationsで定義する

tolerations:

- key: group

operator: Equal

value: monitoring

effect: NoSchedule

▼ NoExecute¶

指定した条件に合致するNodeにはスケジューリングさせない。

なお、実行中のPodが違反していた場合、再スケジューリングさせる。

*実装例*

$ kubectl taint node foo-node group=monitoring:NoExecute

apiVersion: v1

kind: Pod

metadata:

name: prometheus

spec:

containers:

- name: prometheus

image: prom/prometheus

imagePullPolicy: IfNotPresent

# Taintへの耐性をtolerationsで定義する

tolerations:

- key: group

operator: Equal

value: monitoring

effect: NoExecute

.spec.topologySpreadConstraints¶

▼ topologySpreadConstraintsとは¶

異なるリージョン、AZ、Node、にPodを分散させる。

.spec.nodeSelector キーや .spec.affinity キーのスーパーセットであり、これと比べて、Podのスケジューリングをより柔軟に定義できる。

▼ maxSkew¶

.spec.topologySpreadConstraints[*].topologyKey キーで指定した分散の単位の間で、Podの個数差を設定する。

*実装例*

AZが 2 個あるとすると、各AZ間のPodの個数差を 1 個にする。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

topologySpreadConstraints:

- maxSkew: 1

# 異なるゾーンに分散させる

topologyKey: topology.kubernetes.io/zone

▼ topologyKey¶

Podの分散の単位を設定する。

*実装例*

AZを分散の単位に設定する。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

topologySpreadConstraints:

# 異なるゾーンに分散させる

- topologyKey: topology.kubernetes.io/zone

▼ whenUnsatisfiable¶

分散の条件に合致するNodeがない場合の振る舞いを設定する。

*実装例*

分散の条件に合致するNodeがない場合、このPodをスケジューリングさせない。

apiVersion: v1

kind: Pod

metadata:

name: foo-pod

spec:

containers:

- name: app

image: app:1.0.0

topologySpreadConstraints: